تصاویر خصمانه؛ پدیده ای که بدون آگاهی انسان، بینایی ماشینی را به اشتباه می اندازد

از اتومبیل های خودران گرفته تا دوربین های نظارت همگانی هوشمند، جوامع به آرامی به سمتی پیش می روند که به هوش مصنوعی بیشتر از چشمان انسان اعتماد می کنند. اما اگرچه سیستم های بینایی ...

از اتومبیل های خودران گرفته تا دوربین های نظارت همگانی هوشمند، جوامع به آرامی به سمتی پیش می روند که به هوش مصنوعی بیشتر از چشمان انسان اعتماد می کنند. اما اگرچه سیستم های بینایی ماشینی فعلی خستگی ناپذیر هستند، اما ضعف های خود را نیز دارند. کافی است به ویدیوی لاکپشت پایین نگاه کنید؛ تصویری که به چشم شبکه عصبی گوگل شبیه یک لاکپشت نیست و به عنوان سلاح شناسایی می شود.

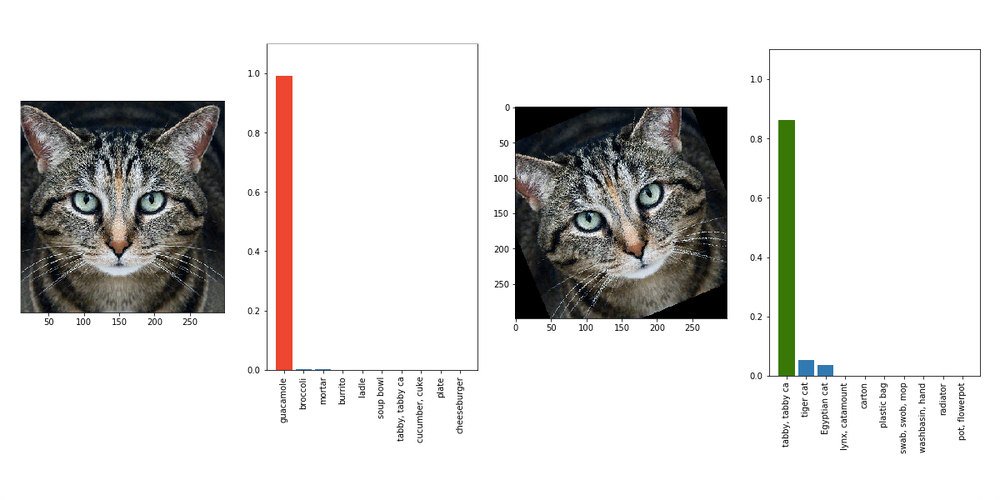

این لاکپشت که به صورت سه بعدی پرینت شده، مثالی است بر پدیده ای که تحت عنوان «تصاویر خصمانه» شناخته می شود. در دنیای هوش مصنوعی، این ها تصاویری مهندسی شده هستند که با الگوهایی خاص، بینایی ماشینی نرم افزار را به خطا می اندازند. در واقع به این تصاویر می توانید به عنوان خطای دیدی برای کامپیوترها نگاه کنید.

همین حالا می توان عینک های خاصی ساخت که سیستم های تشخیص چهره را فریب می دهند یا می توان لایه ای اضافه روی یک تصویر قرار داد تا آن را تقریباً نامرئی کرد. انسان ها این تفاوت را تشخیص نمی دهند، اما برای هوش مصنوعی، انگار که یک پاندا ناگهان تبدیل به کامیون حمل بار شده باشد.

تحقیق در زمینه راه های جلوگیری از این حملات، از همین حالا آغاز شده است و گرچه چنین حملاتی معمولاً بسیار تاثیرگذار هستند، اما کار چندانی به پیش نمی برند. این بدان معناست که اگر تصویر خصمانه را چرخانده یا روی آن زوم کنید، الگوی تازه از چشم کامپیوتر دور مانده و تصویر را به درستی شناسایی می کند.

تیمی از دانشجویان MIT که به تحقیق در این زمینه می پردازند می گویند مردم باید نگرانی هایی درباره شبکه های عصبی داشته باشند. این تیم به عنوان مثال به تابلویی در کنار خیابان اشاره می کند که برای انسان ها، همچون تابلویی معمولی به نظر می رسد اما برای بینایی ماشینی اتومبیل های خودران، مانند عابر پیاده ای به نظر می رسد که ناگهان به کنار خیابان آمده است.

گروه MIT حملات خود را روی سیستم Inception-V3 گوگل آزمایش کرده است. این سیستم به صورت آزادانه در دسترس محققان قرار گرفته تا به آزمایش مسائل گوناگون بپردازند و گرچه سیستمی تجاری نیست، اما با تجاری شدن فاصله زیادی ندارد. اگرچه این حملات روی دیگر نرم افزارهای بینایی ماشینی آزمایش نشده اند، اما هنوز هیچ راه حلی برای مقابله با تصاویر خصمانه وجود ندارد.

البته ناگفته نماند که چنین حملاتی، در بازه زمانی فعلی خطری برای عموم مردم ایجاد نمی کنند. این حملات قطعاً تاثیرگذار هستند، اما در شرایط بسیار محدود. و گرچه بینایی ماشینی روز به روز بیشتر مورد استفاده قرار می گیرد، اما هنوز به قدری به آن متکی نشده ایم که یک پرینتر سه بعدی، باعث بروز فاجعه شود. مسئله اینست که چنین آزمایش هایی، میزان شکنندگی سیستم های هوش مصنوعی را نشان می دهند که اگر حل نشوند، در آینده دردسرساز خواهند بود.

دیدگاهها و نظرات خود را بنویسید

برای گفتگو با کاربران ثبت نام کنید یا وارد حساب کاربری خود شوید.

نمیدونم امکانش هست یا نه ولی کاش ویدیو ها رو هم همینجا توی اپ میذاشتید .

ممنون از مطالب خوبتون .

چه مطلب بی خاصیتی